1.普通にパススルー映像が見える

2.パススルーに重なる映像がズレない

3.現実があるから、仮想の現実感が増す

4.『見るだけ』未体験の視線入力

5.行き届いたアップル流のデザイン

初体験時、Vision Proは過去に例のないデバイスだったので、非常に興奮して記事を書いた。

しかし、興奮し過ぎて、冷静さを欠いていたことも確かなので、どういう体験だったのか伝わるように、あらためて冷静に分析しながらレポートしたいと思う。

正直、Vision Proについてはいまだに感動で筆が走ってしまうのだが、なるべく筆致を抑えて、『Vision Proの本質的な価値』はどこにあるのか、考えて書きたい。

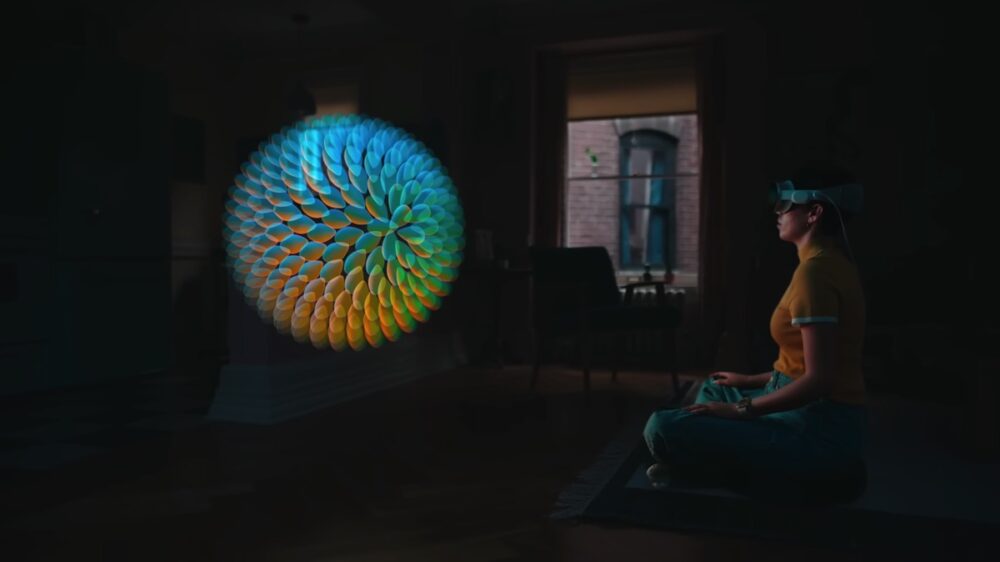

なお、体験取材時には写真やキャプチャは禁じられていたので、画像はアップル提供の動画を許可を得てキャプチャしたものだが、これはイメージ映像でもなんでもなく、取材時にこれと同等以上の解像度、見え方で、さらに立体的にそこにあるものと同じように見えていることを意識して読んでいただきたい。

1.普通にパススルー映像が見える

Vision Proを使うと最初に「ディスプレイが宙に浮かんでいてすごい!」と感じる。これが驚異の体験なのだが、そこを細かく解説しないと伝わらない。この凄さを順を追って説明しよう。

まず、前提条件として『パススルー映像が非常に美しく、歪みや遅れがない。まるで現実のように見える』。他の体験に覆い隠されて、すぐに慣れてしまったのだが、冷静に考えると、これが一番重要なポイントだ。

従来のARは光学的な視界にオーバーレイされるものが一般的。たとえば、Google Glassとか、EPSONのMOVERIOとか、MicrosoftのHoloLensなどは現実の風景は実際に目に見えるもので、その上にハーフミラーを使って、コンピュータで作り出した画像を合成する仕組みになっている。この場合、現実の風景は、実際に光学的に目に見えてるものだから、歪みや遅れがあるわけではない。

ただし、コンピュータ側から映し出す映像は半透明になるし、外側が明るかったり、暗かったりすると、安定した状況では見えない。クルマのHUDなどもそうだが、投映する仮想映像に細かい彩度や明度のディテールを期待することができない。

アップルはこのプランで途中まで開発したのだが、そのプランをボツにしたというウワサもある。『映像を十分なクオリティーにできない』『視野角が狭く視野の中央にしか映像を表示できない』などが問題だったと思われる。アップルの期待する体験を実現できなかったのだろう。

そういえば、かなり前の話になるが、Google Glassを最初に着けた時に驚いたのは、思ったより投映される映像が視野の中で小さかったことだ。MOVERIOも想像するよりずっと小さな映像しか見ることができない。

一方、アップルのVision Proで使われているように、光学的ではなく、ゴーグル外側の映像をカメラで撮影してモニターに表示する手法では、レスポンスの遅れや歪みが大変に問題になる。この方法にVision Proほど深く取り組んで、成功したデバイスは私の知る限り他にない。

たとえば、Meta Quest Proも、同じカタチのパススルーを実現しているが、現実世界の見え方は、ここまでのレベルには到達していない。またデバイス側の空間把握もVision Proほど正確ではない。

これは優劣というより、仮想空間、現実空間、どちらを主眼に捉えているかの違いだと思う。

Vision Proの最初のレポートでは、あたり前に『現実が現実のように見える』という体験を受け止めてしまったが、ここにたいへんなテクノロジーが詰め込まれているはずだ。そして、一番他社が追いつくのが大変な部分だと思う。

12個のカメラと5つのセンサーから入力を得てるとあり、そのうちいくつが外側を向いてるのかはまだ分からないが、それらを合成してユーザーが見る光景を作り出しているのだ。位置にズレがないことを考えると、LiDARの情報も獲得して、その上に映像をマッピングしているのかもしれない。

カメラで撮影した映像をモニターに映し出して見ているにも関わらず、違和感がない。机の上にある本を手に取れるし、コップを正確に持ち上げられる。服のボタンを付け外しできる。手前にあっても歪みがないのだ(たしかに下向きにもカメラが付いている)。

さらに、レスポンスの遅れも感じられない。立ち上がって、ソファーやテーブルの周りを歩いてみたが、普通に歩ける。カーペットのライン上をふらつくことなくたどって歩ける。これも多分すごいことなのだ。

アップルの発表によると『R1チップは、まばたきの8倍高速な12ミリ秒で新しいデータイメージをディスプレイにデータストリームとして伝送します』という。まばたきする1/8の時間でデータを伝送できるのなら、ズレを感じないのも当然なのだろう。しかし、12個のカメラと5つのセンサーから取得した映像を合成して、全体で2300万ピクセルを持つ2台のディスプレイに立体映像が得られるようにストリームするというのは、これまたとんでもないことのように思える。それがR1チップのやっていることなのだろう。

周りの風景は日常的に私が見ている光景と変わらないように見える。わずかに解像度が落ち、彩度は落ちるが、現実の視界と『ほぼ同じ』といえること自体すごいことだと思う。

2.パススルーに重なる仮想映像がズレない

次に、そのまるでゴーグルを着けていない時とほぼ同じように見える風景の中にディスプレイ(や他の仮想映像)がズレずに映っているのが尋常でないのに気付くべきだろう。

他のARデバイスの経験としては、これはちょっとズレたり、ブレたりするものだ。しかし、Vision Proの映像は、先の現実世界の映像に、ピッタリとブレずに乗っている。

これは7年間開発し続けていたARKitの熟成レベルの高さに理由があると思う。

アップルの製品サイトの一番下に、ARで製品を出すことができるサービスがあるが、ARオブジェクトも、机の上にしっかりと置けるようになってきていることにお気付きだと思う。あの現実映像への食いつきの良さが、Vision Proで見ている光景に反映されているのだ。

たとえば、ディスプレイはこちらが動いても同じ空間にしっかりと固定されている。それはVision Proが部屋の形状をしっかりと把握しており、その上に投映したオブジェクトをしっかりと置いているからだ。

机の上に浮かんだディスプレイは、近づいても遠ざかっても、横に行っても同じ場所に浮かんでいる。

3.現実があるから、仮想の現実感が増す

これまで、VR映像ですごい景色や、迫力のある光景を見てきた。しかし、それはVR空間に入ってるからこその経験だ。

対してVision Proの映像は、パススルーで見ている現実空間の上に出現する。仮想空間で見るものと、現実世界の上に出てくるものでは、感覚が違っている。

↓これはイメージ図ではなく、本当にこう見える体験ができるのだ。

たとえば、VR空間内で人物が立っていても、そうそう驚くことはないが、Vision Proだと、自分の部屋にその人物が立っているのだ。それが美少女であれ、サブマシンガンで武装した偉丈夫であれ、自分の部屋に立ち入られると、格段に驚きは増すのはご理解いただけるのではないかと思う。

空間再現ビデオで見る子供たちの誕生日パーティの光景に感動したと書いた。しかし、その意味がどうも伝わり切っていないと感じた。

Vision Proを使ってる私にとって、そこにいるアップルのスタッフが立体的で実存しているのと同じように、子供たちの誕生日パーティも立体的に実存しているように見えるのだ。そんな経験をしたことがあるだろうか? なにしろ、両者ともVision Proの外側のカメラで撮影された映像なのだから、違いがあろうはずがない。

なにしろ、Vision Proで見たすべての視界は、今、現実だと思って見ている部分もカメラとディスプレイを通して見ている光景なのだ。つまり、それは(おそらく)録画可能で、他人と共有可能なのだ。サービスとして提供されるかどうか分からないが、他の人が見ている光景はすべてコピー共有可能。Vision Proなら少なくとも技術的には可能だ。

『現実世界もすべてカメラを通した映像』だからこそ、『そこに描かれるCG世界は現実と区別がつかない』のだ。

映画『アバター2』の一場面をVision Proで見たのだが、映画館の3Dなんて、たいしたことないと思うぐらい3Dだった。

映画館の3Dが、前のスクリーンの奥側に微妙に立体感を感じただけだとすれば、Vision Proは、これまで3D映画のイメージ映像に出てきていた、スクリーンから飛び出して触れそうなところに出てくる映像を実現する。

実際、アバター2のイル(海洋民族が乗るプレシオサウルスのような海生生物)の長い首がこちら側の伸びて来た時には思わず避けてしまったほどだ。

普通にパススルーで見ている映像もすべて立体感を持って表現されているから、そこに登場する仮想映像も、現実と同じ立体感を持つのだ。

これまでの立体映像がすべて色褪せる、『完全な立体感』なのだ。

4.『見るだけ』未体験の視線入力

『見ただけで、分かってくれる』なんてのは恋人ぐらいだ。

そんなデバイスを体験したことがある人なんていないはず。

たとえば、パソコンだったら『見てから』トラックパッドやマウスを操作しているし、iPhoneでも『見てから』画面にタッチしている。しかし、Vision Proは視線入力デバイスなので、本当に見るだけで反応してくれるのだ。

正確にいうと、見る事で選択し、親指と人さし指で『つまむ』動作をすることで『タップ』する。このタップも、別に手を持ち上げてする必要はなく、デスクの上や、ヒザの上に腕を置いたままでも問題ない(Vision Proはカメラで見ているので、Vision Proから見えている必要はある)。

この視線入力も、タップも、現時点でほとんど誤動作がない。ちょっとでも引っ掛かりがあったり、不自然な感じがあれば違和感が発生すると思うのだが、まったく違和感なく動作するのだ。

この視線入力は、内側に備えられたセンサーが、瞳の動きを検知してるのだと思う。これもまた、他の企業が今から追いつくのはとても困難な部分だ。

『見ただけで、分かってくれる』。Vision Proは初めての心通じるデバイスなのだ。

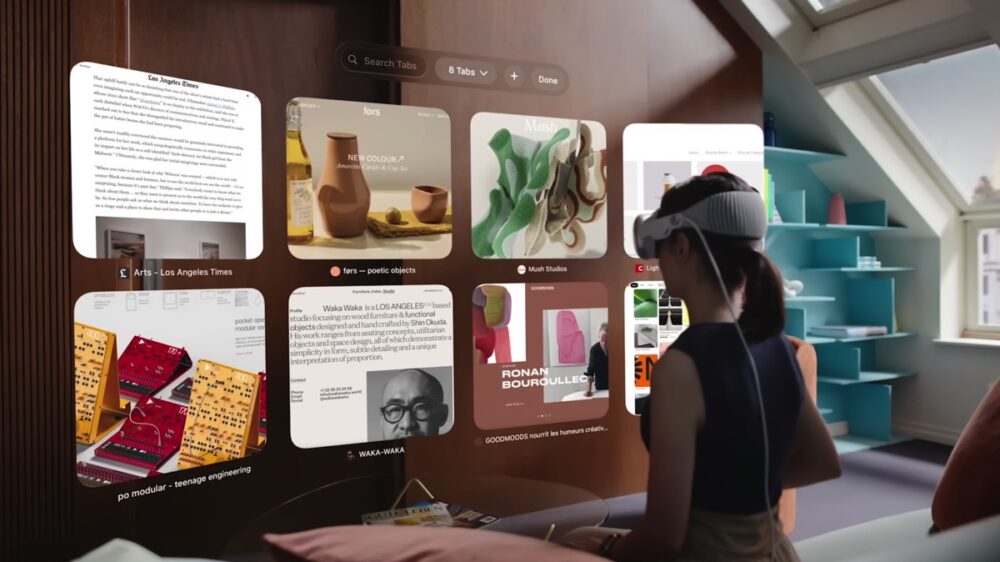

5.行き届いた、アップル流のデザイン

軽視されがちだが、Vision Proにおいて非常に大切なのは、すべてに行き届いたデザインだと思う。

ウインドウはどこにどう表示されるべきか? どのような半透明度合いを持つべきか? そこに表示される文字の色は? アイコンはどういうカタチをしているべきか? (仮想の)ウインドウが(リアルの)床面にどういう影や反射をもたらすべきか? どんなフォントがどのサイズで使われるべきか? その時にどういう色が使われるべきか? まで、こと細かに決められている。

(参考)

WWDC23:visionOSの空間デザインの原理について紹介

https://www.macotakara.jp/visionOS/entry-44877.html

仮想空間の中だと、誰でもデザインできてしまうので、他のデバイスではエンジニアが雑にデザインしているケースも多いのだと思うが、Vision Proの中の空間は、OS側もアプリ側もグラフィックデザイナーがしっかりとデザインしている。Macの画面は美しい、iPhoneのアプリは見やすい……と思っている人は多いと思うが、それにはちゃんと理由があるのだ。

Vision Proで我々が目にするものは、すべてキチンとデザインされている。それがとても心地よいのだ。

最終的な完成品を最初に出してくるアップルの凄さ

筆者が知る限り、6年以上前からアップルはARKitを作っており、この『空間コンピューティング(Spatial Computing)』をどうデザインすべきか試行錯誤を続けてきている。

その集大成が、Vision Proだ。

絶対的な完成品ができるまで、秘密裏に試行錯誤を繰り返し、完全に完成した製品ができたら、発売して、あとは頑としてカタチを変えないのがアップルのスタイルだ。

iPhoneも、iPadも、ホームボタンがなくなったぐらいで、そのアイコニックなデザインはまったく変わっていない。MacBook ProやMacBook Airもそうだ。つまり、Vision Proも世に出たからには、当分はこのスタイルで販売し続けるはずだ。おそらく、人々の反応も、それにどう多くの人が慣れていくのかも、すべて計算済みなのだと思う。

40分ほどのVision Pro体験を、ずっと反芻して考え直して、その本質的に優れた点はどこにあるのか、考えて得た現時点での結論はここに挙げた5点だ。

1.普通にパススルー映像が見える

2.パススルーに重なる映像がズレない

3.現実があるから、仮想の現実感が増す

4.『見るだけ』未体験の視線入力

5.行き届いたアップル流のデザイン

もちろん、仮想映像を補強する立体音響とか、こちらの表情を出す仕組みとか、掘り出せばまだまだいろいろあるが、『なぜ、我々が驚いたのか?』を掘り下げると、以上の5点になる。

体験してない人が、Vision Proというハードウェアを理解しようとすると、『パススルーを備えたVRゴーグル』だと認識すると思うのだが、そういうことではないのだ。

たしかに、『スマホ』を、『大画面タッチパネルを備えた携帯電話』だとすれば、BlackBerry 7730も、W-ZERO3も『スマホ的存在』であっただろう。しかし、『スマホの祖』は初代iPhoneだ。それと同じことがこのVision Proにもいえる。新たな『空間コンピューティング』を提案できているのは、Vision Proだけだ。今後、幾多のデバイスがVision Proを模倣しようとすると思うが、上記5項目を模倣するのはかなり難しいように思う。

いくら筆を尽くしても、この凄さを体験していない人にお伝えするのは難しいと思う。しかし拙い筆者の文章から、Vision Proというものがどういうものなのか、少しでも拾い上げていただけると幸いだ。

(村上タクタ)

関連する記事

-

- 2026.01.31

心配されたスマホ新法の運用だが、我々アップルファンにとって最悪の事態は避けられたようだ

-

- 2026.01.30

AirTag(第2世代)実機レビュー。AirTag愛用者が見る違いとは?

-

- 2026.01.08

アップルが新春を彩るコンテンツを発表

![Dig-it [ディグ・イット]](https://dig-it.media/wp-content/uploads/2022/09/dig-it-1-1.png)