「Vision Proに搭載されるかどうかは、お答えできません」

「Vision Proって何に使うの?」「Apple Intelligenceって何に使えるの?」とはよく聞かれる話だが、両方が組み合わさったら何が起こるかを、推測している記事は意外とない。WWDC24で発表されたApple Intelligenceが、WWDC23で発表されたVision Proのためのものであるのは当然なのに!

発表ではApple Intelligenceは、iPhone、iPad、Macに搭載されることになっている。その後、「それ以外のプラットフォームに搭載される」とのことだ。

「それ以外のプラットフォームって何ですか? Vision Proには搭載されますか?」と質問すると「将来の計画についてはお話できません」という回答が返ってきた。そりゃそうだ。

しかし、visionOSはiPadOSをベースに作られているし、Vision ProはM2チップを搭載しているんだし、つまり、どういう実装にするかはともかくとして、スペックとしては搭載できるはず。

Hey Siri ! この看板を日本語にして!

では、搭載すると何が起こるか?

簡単に言うと、映画『アイアンマン』で、トニー・スタークが使うJ.A.R.V.I.S.みたいなものが現実になる。

” I’d like to open new project file, index as Mark II. “

と言ってトニー・スタークは、初期型アイアンマンの3D CAD映像を目の前の空中に表示させ、J.A.R.V.I.S.に口頭で指示し、手を空中にひらめかせながらアイアンマンのCAD図面を操作し、Mark IIとしていわゆる我々が知ってるアイアンマンの開発作業を進めていく。

同じことを、J.A.R.V.I.S.ではなくて、Siriに頼んで行えるようになるはずだ。

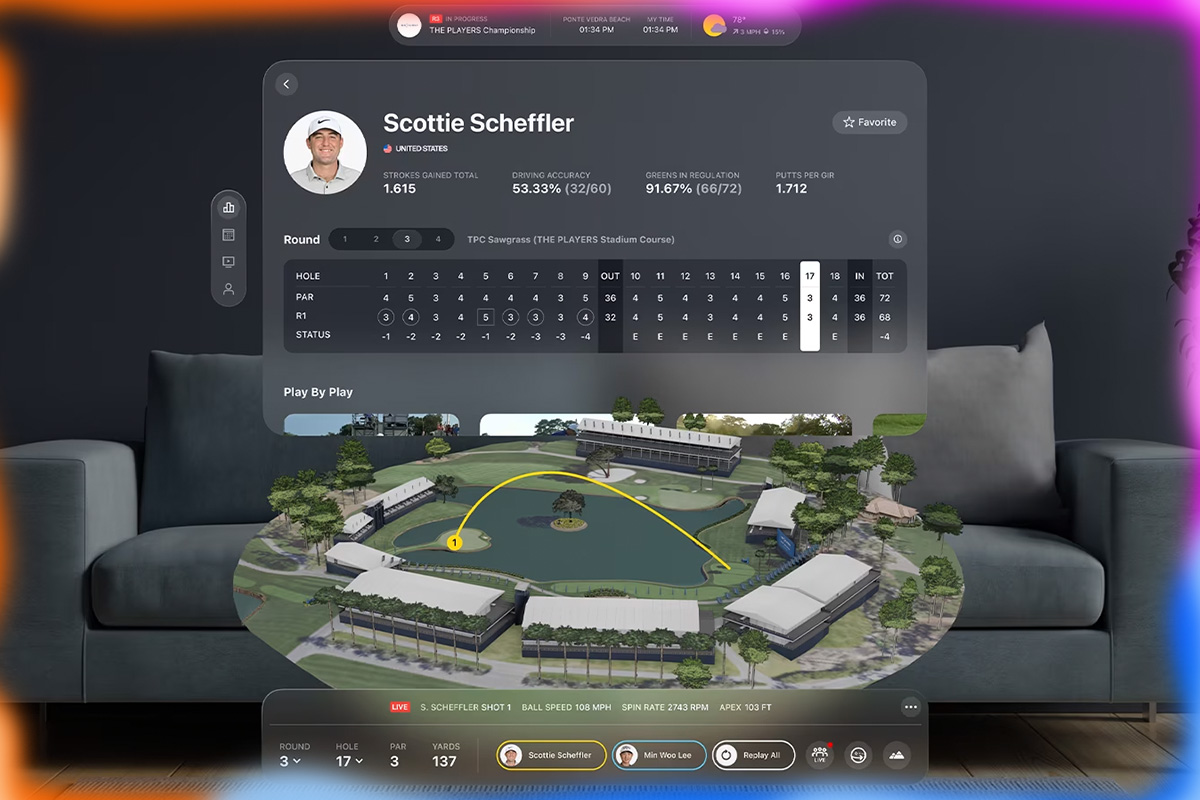

Vision ProにApple Intelligenceが組み合わされば、Vision Proのカメラを通して現実世界を認識し、Apple Intelligenceが関連する情報をリアルタイムでオーバーレイ表示できるようになる。例えば、街並みを歩いている際に、歴史的な建造物やお店の情報、ばったり会った知人の名前や経歴などを視界に浮かび上がらせることができる。

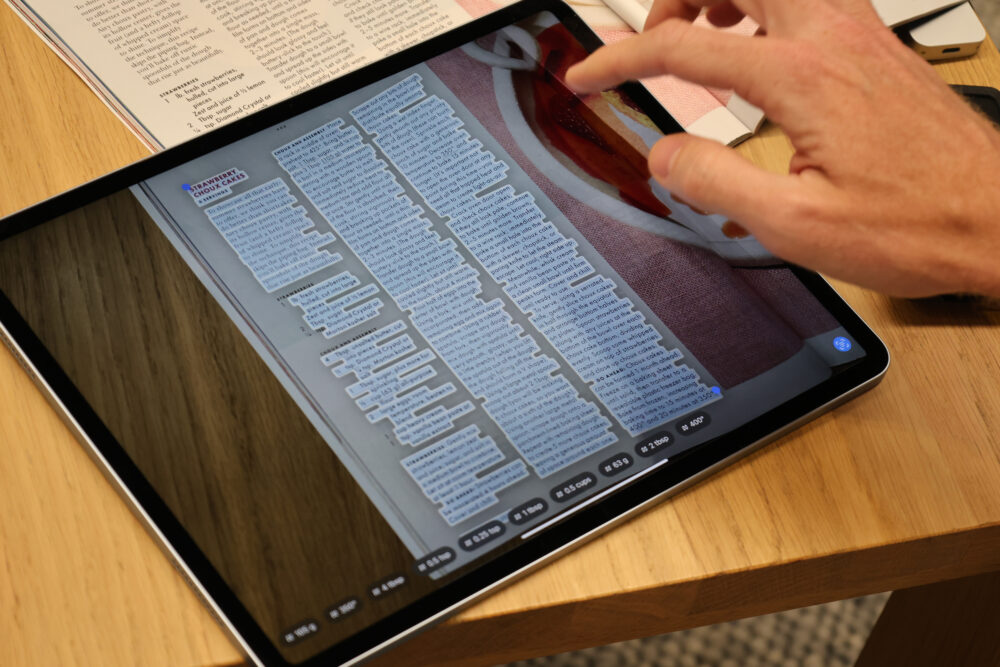

Vision Proのジェスチャー認識機能とApple Intelligenceの言語処理能力を組み合わせれば、現実世界を指さしたり、ジェスチャーを行うだけで、情報の操作や翻訳が可能になる。目にしたドキュメントが外国語でも、日本語に翻訳したものをオーバーレイさせられる。外国語の話を聞いて、それを瞬時に翻訳して、音声で聞くこともできるし、文字表示してもらうこともできるだろう(文字表示の方がラグがなくて便利そう)。

現状のVision Proでメールを開いてテキストで返事を書こうと思ったら、なかなか手間がかかることはご存知のとおり。

でも、Apple Intelligenceの乗ったVision Proなら、ソファーに座ったまま、ジェスチャーでメールをパラパラめくりながら、イベントの招待状にも「参加するって返事しておいて」で、生成AIが適切な文面を生成してくれるはずだ。「もうちょっとフレンドリーに」とトーンの調整もできる。

今、Vision Proで我々が不便に感じることは、Apple Intelligenceの搭載ですべて解決するのだ。

Vision ProはApple Intelligenceがあってこそ便利になる

ご存知のようにVision Proもまだβ版のような状態だし、Apple Intelligenceにいたってはローンチもされていない。おそらく、それぞれは別々に熟成されて、融合するのだろう。

Vision ProはApple Intelligenceがあってこそ便利になるし、Apple IntelligenceはVision Proがあってこそ、最大の威力を発揮するはずだ。

この2つの融合が発表されるのはWWDC25だろうか?

驚くような世界がやってきそうだ。

(村上タクタ)

関連する記事

-

- 2025.12.31

M5搭載Vision Pro、M2モデルとどう違う? 登場の意味は?

-

- 2025.10.27

Amazonで買ったVision Pro用のストラップが便利

![Dig-it [ディグ・イット]](https://dig-it.media/wp-content/uploads/2022/09/dig-it-1-1.png)