Vision Pro日本発売は6月28日! 予約受付は6月14日午前10時から

今回もWWDCはオンラインを基本として、限られた開発者とメディアだけが、Apple ParkのMac Caféの屋外に設けられた特設会場に招待された。

今回も冒頭にティム・クック、そしてクレイグ・フェデリギが実際に登壇して挨拶をした他は、編集されたムービーでのKeynoteとなった。

ただ、今回は、終わった後に、Steve Jobs Theaterに移動してクレイグ・フェデリギ(Appleのソフトウェアエンジニアリング担当上級副社長)とジョン・ジャナンドレア(同機械学習・人工知能戦略担当上級副社長)に、iJustine(1000万視聴者を抱えるYouTuber)が、インタビューするというセッションが行われた。

ハードウェアの発表がなく、実物に触れるタッチ&トライの機会がなかったので、それに代わる催しともいえる。

まずは、簡単にVision Proの話を。

ついに、Vision Proの日本発売がアナウンスされた。

予約注文は6月14日午前10時から。発売は6月28日。価格は59万9800円から。筆者はUS発売時に512GBモデル(入手性の都合で)、ケース、バッテリーホルダー、アップルケアなどと一緒に買っておよそ日本円に換算して、75万円だった。ざっくり計算してみると、その時の購入価格に近いレートとなっている。AppleCare+だけで8万9800円というのにはしびれるが、初期モデルだけにトラブルが起こる可能性は高い。ある日電源が入らなくなった……などという可能性があることを考え、筆者は加入した。

本日公開されたvisionOS 1.2で、OSレベルで日本語の選択が可能になり、日本語キーボードにも対応となった。

本機は、何度もレポートしているように、購入者へのマッチングに手間がかかるデバイスなので、アップルストアに専用の体験用ソファーが用意され、フィッティングなどを行う準備が、今、まさに行われてると思う。オンラインでも購入できるはずだが、Light Sealなどのフィッティングは店頭で行うことをお勧めする。Light Sealのフィッティングによっても、けっこうユーザー体験は違うものだ。

また、発売までに、日本のアップルIDも利用できるようになるはずだ。現状、アメリカのIDが必要で、有料のアプリを買うためにはアメリカのクレジットカードが必要なのでかなり面倒。また、技適もvisionOS 1.2から表示されるようになっている。

プライバシーデータを扱いオンデバイスで動作する『Apple Intelligence』

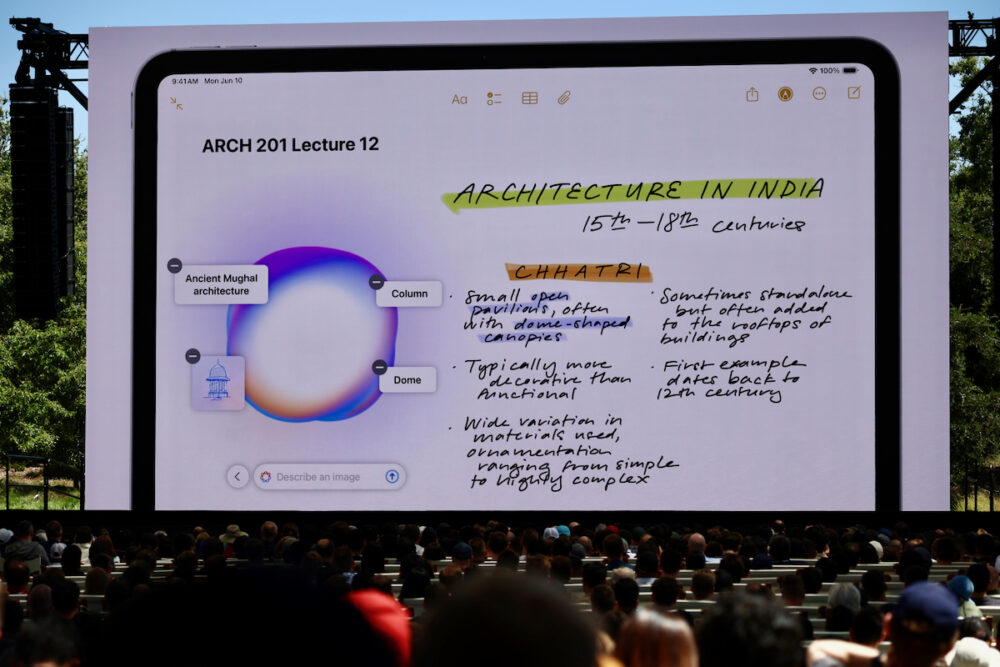

すべてのOSが細かくアップデートされているので、伝えたいことはいっぱあるが、今回はアップル製の生成AI、『Apple Intelligence』にフォーカスしてご説明しよう。

現在、生成AIがテクノロジーの世界を大きく変貌させているが、アップルもそのテクノロジーを導入することになる。

しかし、他社が大きなサーバーモデルで、強力な処理能力を持つモデルを開発することが多いのに対して、アップルは基本的には本体内のApple Siliconに内蔵されたNeural Engineを使って、Apple Intelligenceを実現している。

Neural Engineとは、2017年発売のiPhone Xに搭載されたA11 Bionicに初めて搭載されたNPU(Neural Processing Unit)で、これまでもずっと画像の解析や、言語解析など、機械学習的な処理に使われてきたが、アップルはそれを表立っては『AI』と言ってこなかったので、アップルがAIに強い印象はなかったかもしれない。またChatGPTがプロンプトを使ったので、プロンプトを使うのがAIという印象が広がったが、それだけがAIというわけではない。

しかし、近年Apple SiliconはNeural Engineのパフォーマンスを大幅に上げてきており、従来の使い方だけでは「なぜ、そこまでの性能を確保する?」という印象だったので、Apple Intelligenceの登場で、ようやく「このためにNeural Engineの性能を上げてきていたのか!」と腑に落ちた。つまり、アップルは2017年からずっと、この地点を目指して(明確にここまでのビジョンがあったのかは分からないが)Aシリーズチップ、Mシリーズチップに搭載されるNeural Engineの性能を向上させてきたということになる。

Apple Intelligenceの特徴は、『プライバシーを守って、オンデバイスで動作する』というところにある。

スケジュール、連絡先、メールやメッセージなど、プライバシーを必要とするデータを総合的に処理するには、オンデバイスで行う必要がある。ハードとソフトを一貫して開発するアップルだからこそ、Neural Engineほどの処理能力のあるチップを開発して端末に積んでおくことができたのだし、プライバシーにこだわって、アップルさえもユーザーのデータには手を触れられない仕組みになっている……というセキュリティ性の高さがあったから、オンデバイスでユーザー情報をApple Intelligenceで処理する……というゴールにたどり着けたのだといえる。

複数のアプリを横断して処理してくれる!

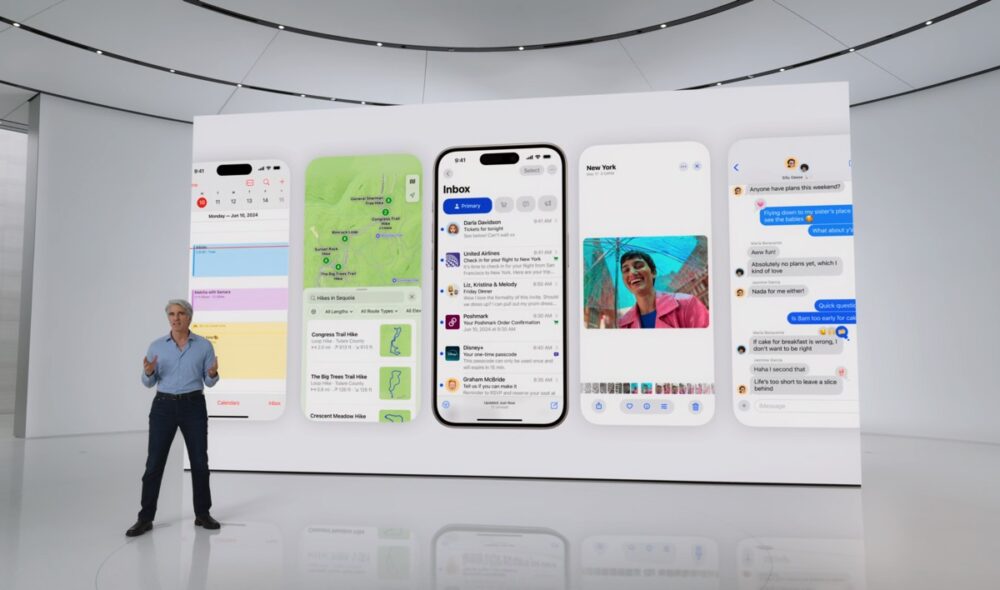

では、具体的に何ができるのか? Keynoteで示された例を持って解説しよう。

たとえば、『娘の演劇の発表会が予定されているのに、会議の予定が後ろにズレた。何時までにオフィスを出れば娘の演劇の発表会に間に合うのか?』という課題が発生したとする。

従来だったら、娘とのメッセージのやりとりを探し、発表会の会場と開演時間を把握し、そこに間に合うには、カレンダーに掲載されている遅延してきた会議を終えてから間に合うのかどうかを判断しなければならない。その間にはマップアプリで移動にかかる時間を調べたりしなければならない。

しかし、Apple Intelligenceが搭載されたiPhone/iPad/Macなら、Siriに「会議が延びた。何時までに出れば娘の発表会に間に合う?」と聞けばいいのだ。そうすれば「○時○○分までに会議を終えて、○○駅に向かい、○時○○分の電車に乗って下さい」と教えてくれるようになる。

Siriは、あなたのコンテキストを知っているから、『娘』が誰で、『発表会』が、何を意味しているのか分かるのだ。さらに、移動のために交通機関が必要であることも、その時間の調べ方も分かってる。

これまで、手間だった連絡先やカレンダーの管理が簡単に!

ローカルのApple Siliconで手に負えないような処理が必要であれば、アップルはユーザーの許可を取って、セキュリティで守られたPrivate Cloudと暗号化された通信を行い、処理を行う。これにより、オンデバイスだけでは行えない規模の処理も実現している。もちろん、このPrivate Cloudはユーザーの領域だけに区切られており、ユーザーデータが学習データとして使われることもない。

iPhoneが登場する前から、連絡先やカレンダーというアプリはあるが、最近その利便性の向上は停滞していたと思う。

メールが来たらその署名欄をコピペして連絡先データを作り、メールの返信の文案を考え、予定をカレンダーに手作業で入力し……という作業が、我々の仕事時間のかなりの部分を占めていたが、我々はその作業から解放されるのだ。

書類に免許証番号を入れる必要があれば、(写真を撮ってあれば)写真から免許証番号を取得してくれるし、メールのフライトスケジュールを取得するだけでなく、リアルタイムの運行状況も確認して空港に向かうべき時間をアドバイスしてくれる。

それらの説明書きが長ければ要約もしてくれる。それらが、すべてOSに埋め込まれた仕組みからスムーズに実行可能なのだ。

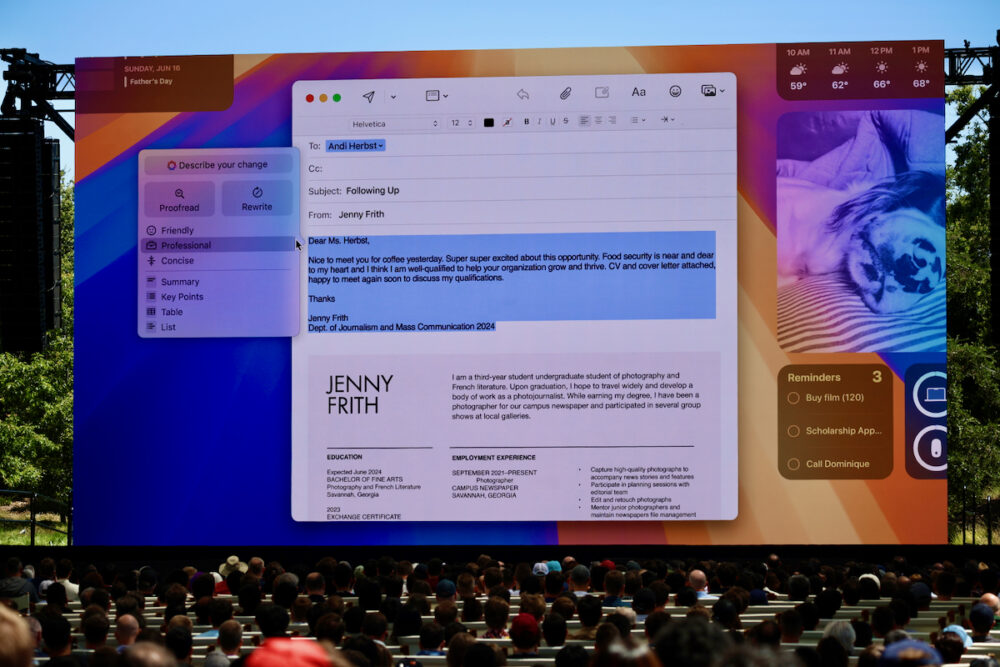

文書も生成可能!

これまで、他社製生成AIで実現していたことであるが、文章の生成も可能。受け取ったメールにをApple Intelligenceが要約してくれるので、それに対してイエスなのかノーなのかさえ選択すれば、それに見合った返事も生成してくれる。「もう少しフレンドリーに」とか「もっとフォーマルに」というような指示も可能だ。

もちろん、自分自身の創造性を発揮した文章が必要なこともあるだろうが、Apple Intelligenceが生成してくれる文章で良い部分は任せて、自分にしか出来ない作業に時間を費やした方がいいだろう。

メールや、書いたドキュメント(そして、今私が書いているようなWordPressの記事)を校正してもらうこともできる。入った修正をひとつひとつ解説文も含めて確認することもできるし、一括で反映してしまうこともできる。

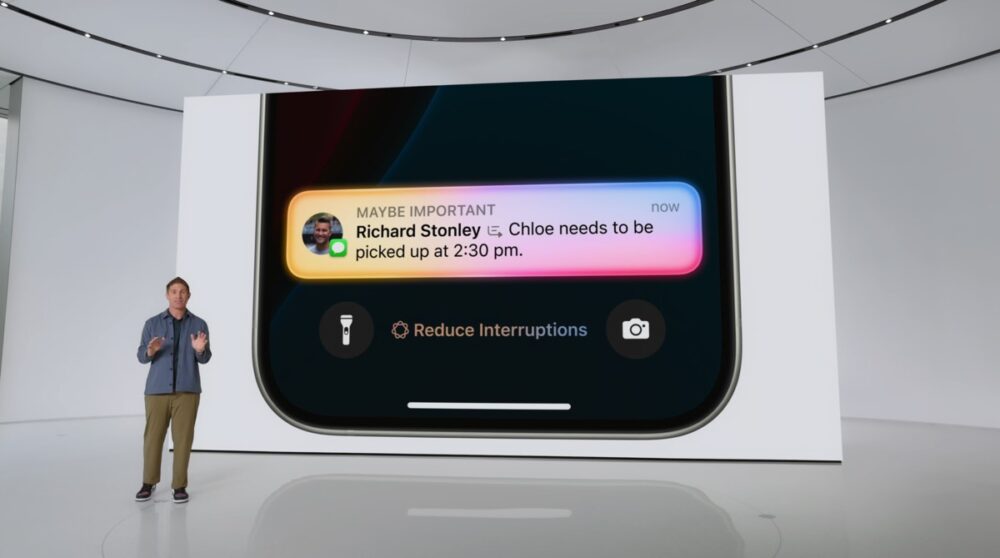

「空気を読む」通知の進化

みなさんの日常も、私と同じように『通知』に追われていることと思うが、Apple Intelligenceはこの通知も適宜管理してくれる。

まず、メールやメッセージの下に表示される内容テキストは、文頭が表示されるのではなく、概要が要約されたものになる。だから、それを見るだけで、今開くべきメールかも判断できる。

また、集中モードの設定に応じて、今知らせなければならない通知かどうかを自動的に判断して知らせてくれる。集中して仕事をしているモードであれば、急を要さないメールの通知は出さないし、「娘の幼稚園のお迎えの時間が変更された」というような、今開かなければならない緊急性の高いメールは、通知を出してくれる。

画像の生成も可能で、Apple Pencilで円を描くだけで、そのドキュメントの文面に応じた挿し絵や説明図を生成できるという。ただし、絵のテイストはアニメーション、スケッチ、イラストレーション……からの選択ということになっており、フォトリアリスティックな表現はできなさそう。

フェイク画像などを含めて、問題の多そうなフォトリアリスティックな画像の生成はしない……というあたりに、アップルの生成AIに対する慎重な姿勢がうかがえる。

また、Apple Intelligenceはローカルの個人情報にフォーカスしたAIなので、補完する意味でOpenAIのChatGPTとの連携も用意されている。OSとしては、アップルデバイスローカルのApple Intelligenceはユーザーのプライバシー情報含めローカルで動作することにフォーカスしているが、ウェブにある大量の情報を持っているChatGPTに聞いた方が良い答えが得られる場合もある。主に専門領域のテーマについては、一般の広い情報が公開されているウェブの知識を広範囲に学んでいるChatGPTの方が良いということだ。

日本は来年。iPhone 15 Pro以上か、Mシリーズチップ

ちょっと残念なのが、このApple Intelligenceの導入が、まず米国英語からだということだ。米国英語では、夏から試験的に導入され、秋には米国英語の一般ユーザーはベータ版として使うことができる。日本語を含む他の言語は来年に向けて追加されるという。

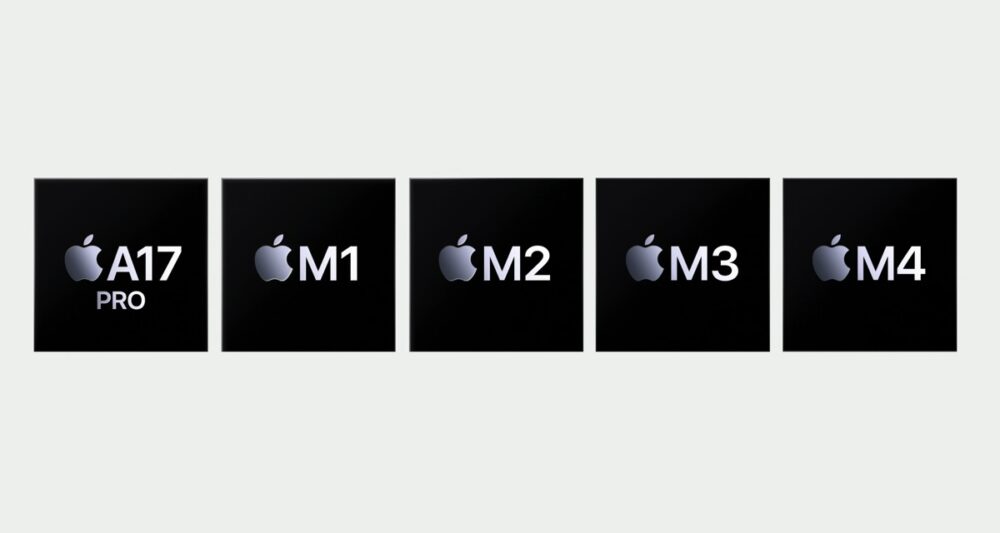

また、Apple Intelligenceを使うためには、iPhone 15 Pro搭載のA17 Pro、もしくはMシリーズチップが必要ということで少々敷居が高い。しかし、オンデバイスで生成AIを使うには、それほどのパフォーマンスが必要になるということなのだろう。

我々が使えるようになるまで、しばらく時間がかかりそうだが、久々に我々の生活を一変させてくれそうな大きなアップデートだ。

生成AIの積極的利用としては後発になったアップルだが、『多くの人々の日常に本当に必要なのは、どういう実装なのか?』を根本から考えた仕組みになっているのは、さすがだ。

たしかにMacintosh前にもパソコンはあったし、iPodの前にもシリコンオーディオプレイヤーはあったし、iPhoneの前にもタッチパネルを持った電話はあった。

しかし、マニアが使いこなす道具ではなく、the rest of usたる、詳しくないユーザーが必要としている実装を実現してくるのは、今回もアップルだということになるのかもしれない。

アップルは、『AI for the rest of us(残された人たちのためのAI)』と表現した。まさに、その言葉の通りだと思う。

(村上タクタ)

関連する記事

-

- 2026.02.18

文字起しイヤフォン『Zenchord 1』ファーストインプレッション

-

- 2026.01.31

アップル春の学割キャンペーンをスタート

-

- 2026.01.31

取材の文字起こしに、Nottaが欠かせなくなっている

-

- 2025.12.31

XREALの長時間稼働を実現するXREAL Neoを体験

![Dig-it [ディグ・イット]](https://dig-it.media/wp-content/uploads/2022/09/dig-it-1-1.png)