めずらしく、サムスンの取材にお招きいただいた

ご存じのようにThunderVoltはアップルデバイスを中心に記事を書いている。これは筆者が、アップルデバイスが好きだからだ。できればAndroidデバイスについても記事をお届けしたいと思っているが、不得手なことをするよりも、アップル製品にフォーカスしている。

しかし、最近、なぜだかサムスンのPR事務局さんからご連絡をいただく。サムスンについて記事を書いたのは、『フリック!』創刊当時、つまりGalaxy Sとか、S2の頃(iPhoneでいえば4Sや5の頃)。その頃は広報機材をお借りして、撮影したりしたことはあるが……。そんなにご無沙汰している人間にご連絡いただくなんて、最近、書いている原稿が評価されているのだろうか……と、ポジティブに考えてみたりする。

スケジュールがカブっていたりして、新製品体験会にはお邪魔できなかったのだが、大阪万博会場でのサムスンとクアルコムの副社長のAIに関する対談を聞けるとご招待をいただいた。それはそれでiPhone以外のAIについて勉強になりそう。講演で勉強させてもらえるならそれはラッキーというものだ。行く予定がなかった大阪万博だが、取材には少し自由時間があるというから、チラリと大阪万博を観られるかな……という下心もあった(笑)

サムスンとクアルコムはどう協力しているか?

対談は韓国語で行われ、それを日本語への同時通訳で聞くことができた。

ソン・インガン氏は、サムスン電子常務兼MX事業部テクノロジー戦略チーム長。スペンサー(サンピョ)・キム氏はクアルコムコリアの副社長。

世の趨勢で、サムスンも独自のAIを開発している。そして、それを支えるのがクアルコムのチップセット。筆者同様アップル製品のことしか知らないであろうThunderVolt読者のみなさんに説明しておくと、AndroidもiPhoneと同じく、CPU、GPU、NPUなどの処理ユニットをひとつのチップセットにまとめて搭載している。しかし、そのチップセットを製造しているのは、1社ではなくクアルコム、MediaTek、Google、サムスンなどに分かれている。そして、サムスンの最上位機種に搭載されているのがクアルコムのSnapdragon 8 Gen 3だ。

つまり、サムスンのAI戦略において、クアルコムのサポートは大変重要ということになるので、このお二人が登場したというわけだ。

オンデバイスAIとマルチモーダルAIというアップルと同じ到達点

さて、Androidというか、Google勢にはGemeniがあるが、なぜサムスンは別にGalaxy AIを開発しなければならないのか? Geminiは基本、クラウドベースで動く。つまり、サムスンには、ローカルでクイックに動き、個人情報を保護できるオンデバイスAIが必要だったということだ。

サムスンのGalaxyシリーズは、Androidの上にOne UIというユーザーインターフェイスをかぶせている。メモや、メールなどのアプリも独自のものが搭載されている。それと同じく、One UIと連携して動くGalaxy AIが用意されているというのだ。

我々アップルファンに分かりやすくいうと、Apple Intelligenceがローカルで動き、一部の機能がクラウドのChatGPTと連携しているのと同じように、Galaxy AIがローカルで動き、クラウドAIとしてはGeminiが連携するというイメージだ。

ソン氏は、まずオンデバイスAIとマルチモーダルAIという概念について、説明した。

オンデバイスAIは先ほど述べたように、クラウドで動くGeminiに対して、ローカルで動くGalaxy AIの立ち位置だ。ローカルで動くから、個人情報を守ることができ、個人の情報をAIで処理することができる(たとえば、業務上、クラウドに上げることのできないメールの返事を書くとか)。また、クラウドで処理するよりもレスポンスにおいて優れている。

マルチモーダルAIは、たとえばテキスト情報だけでなく、人間のように目で見た情報、耳で聞いた情報、手で触れた情報など、現実世界に繋がる多くの形式の情報を扱えるAIということ。

AIの利用率が高まっている

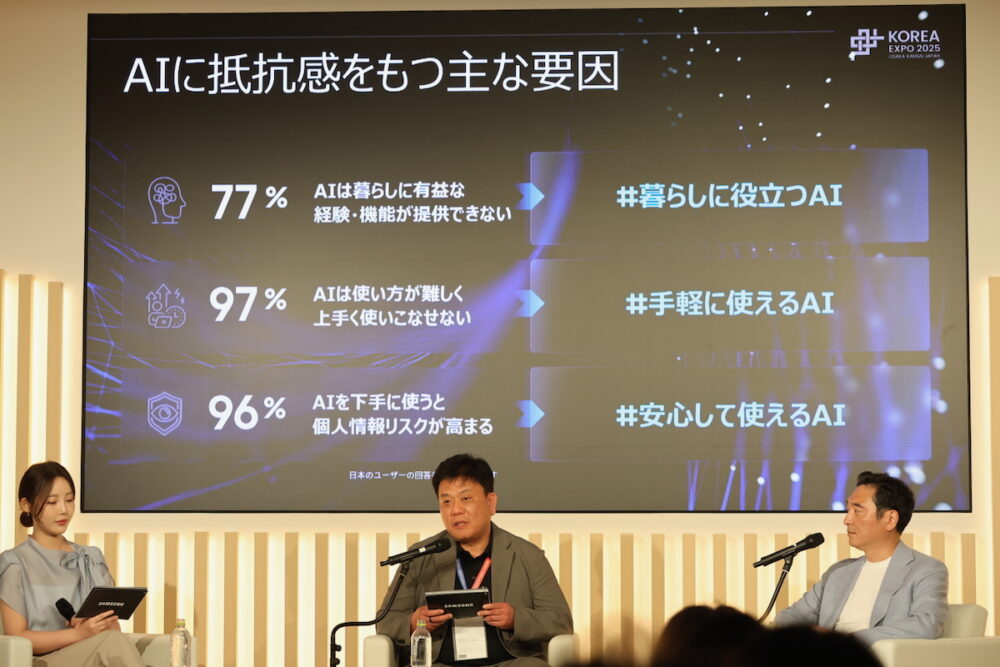

ソン氏によると、実際のところ、この半年でAIの利用者は2倍に増えており、Galaxy S25ユーザーの70%以上がGalaxy AIを使用しているとのこと。利用目的はクリエイティブワークが中心だという。

しかし、逆にAIを使っていない人も多く、その理由は『実用性への疑問』『操作の複雑さ』『プライバシーへの不安』などが挙げられるという。

サムスンはこの不安を解消するのがカギだと考えているという。

クアルコムのチップセットが支えるAI

キム氏によると、クアルコムAIを『新しいユーザーインターフェイス』と位置づけ、より直感的で、ユーザー中心のユーザー体験を実現するために開発を続けてきたという。

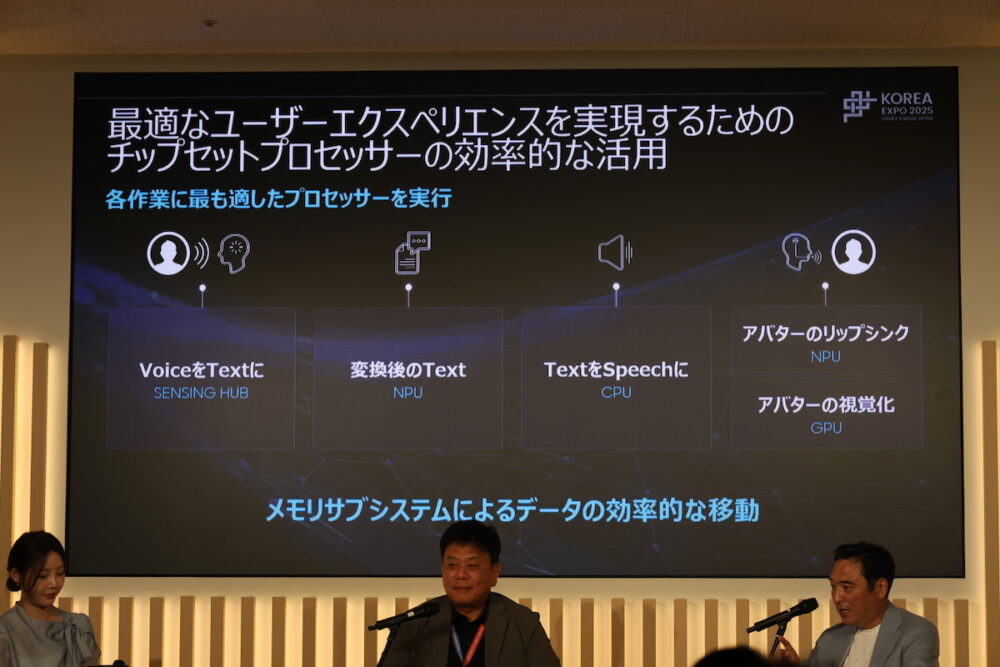

CPU、GPU、NPUなどのチップセット構成要素を自社で設計し、それらを有機的に連携・管理することで、AI体験を最大化するのだという。

たとえば、ユーザーが話したことをアバターに話させるというアクションひとつ取っても、SENSING HUB→NPU→CPU→NPU/GPUがそれぞれ連携しておこなっているのだという。これらを連携させるために、メモリサブシステムを活用して、効率的にデータを移動させている。

具体的には、画像を丸で囲むだけで、画像認識+翻訳+情報取得をしたり、音声操作で試合日程を伝えるだけでカレンダー登録、家族への登録まで行ったり、外国語メニューを撮影すると、AIが食べ方を解説してくれたりするという。これが実際にちゃんと動けば、停滞しているSiriより便利そうだ。

その他、画像や動画から不要なものを消し去ったり、録画の風ノイズを消したり、リアルタイム翻訳や、通話内容のテキスト化、要約など、オンデバイスAIが行えることは数多い。このあたりは、Apple Intelligenceが行うことと同様。どちらがどのぐらい上手くできるかというのはあるが、到達するところは最終的には同じになってくるだろう。

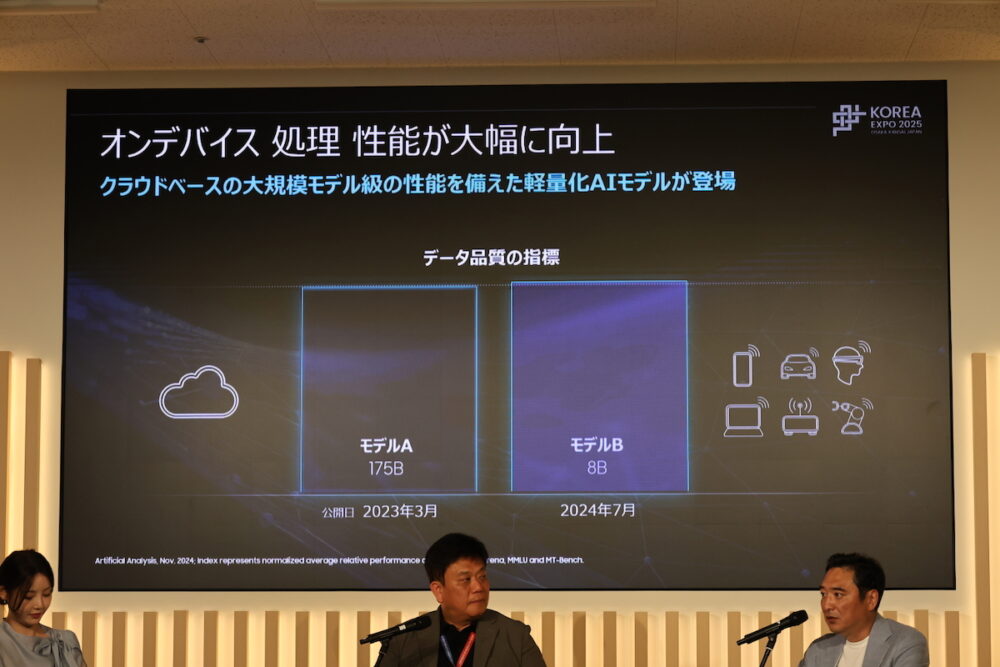

このあたりを推進できる理由は、AIのモデルの軽量化にある。2023年3月に公開されたモデルは175B(ビリオン:10億)パラメータ必要だったが、2024年7月に公開されたモデルは8Bパラメータで同じことができるという。これならオンデバイスでできることも増す。

もちろん、オンデバイスAIにおいては、ユーザープライバシーと、セキュリティにおいても安心できる環境を実現できる。データの安全を保障できることと、データの利用可否の『決定件』をユーザーに戻すことが大切だということだ。

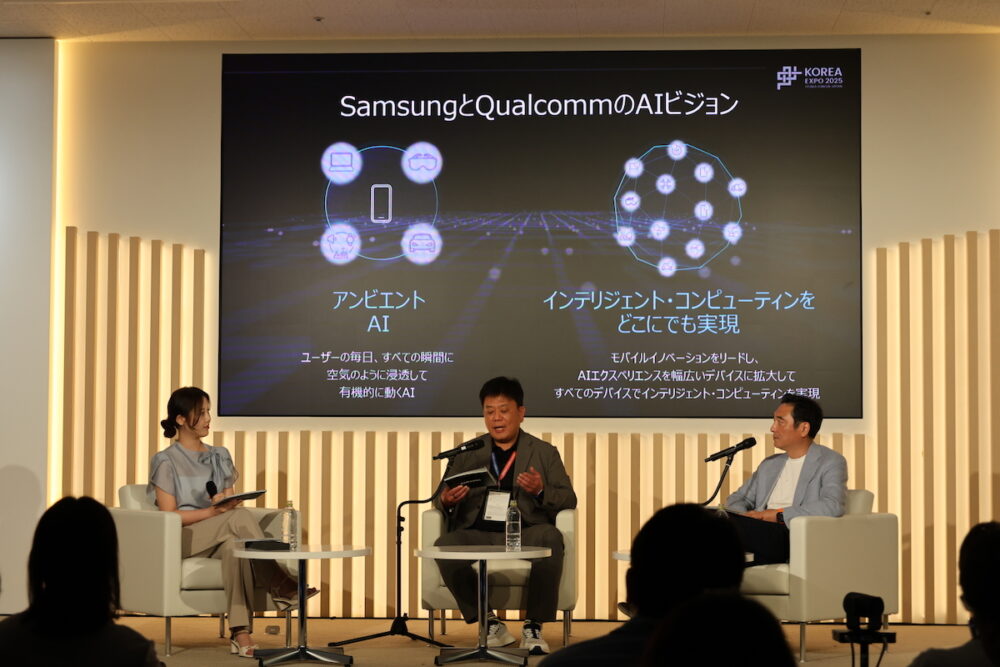

サムスンとクアルコムのAIに関するビジョンは、アンビエントであること……つまり、日常に溶け込んで目立たず活用できること、そして、幅広いデバイスで活用することにあるのだという。

そういう意味では、ビジョンはアップルのApple Intelligenceと通底するところがある気がする。

具体的にどのぐらい違うのかは、実際に使ってみないと分からないところだが……。

万博も観られた

対談の取材後、万博会場を少し散策する時間があった。どのパビリオンも混んでいて、あまり個別のパビリオンを見ることはできなかったが……複数の国が集まっているコモンズ・パビリオンや、トルクメニスタン、カタールの展示を見ることができた。

もしかしたら、長い行列のパビリオンは面白いのかもしれないが、筆者は行列が不得手なので(といってもアップル製品やApple Storeのために並ぶのは平気だが(笑))、ついつい「並んでまで見なくても……」と思ってしまうのかもしれない。筆者は万博に向いてなかった(笑)

韓国館はお招きいただいたので、並ばすに見ることができた。感謝。

作曲家であるおじいさんの書きかけの楽譜が、ピアノに隠されていていてそれを孫娘が音楽として完成させて歌って踊る……K-POPやサムスンの技術などを表現したというコンテンツだった。

(村上タクタ)

関連する記事

-

- 2024.11.19

期間限定で8月1日スタート! 電子書籍で読むKOMINKAと地域の近未来

![Dig-it [ディグ・イット]](https://dig-it.media/wp-content/uploads/2022/09/dig-it-1-1.png)